<데이터마이닝>

1. 개요

방대한 양의 데이터 속에서 숨겨진 규칙, 패턴 등을 찾고 예측 및 의사결정에 활용가능한 가치를 탐색, 이렇게 발견된 규칙 및 패턴을 컴퓨터가 학습하는 것이 기계학습, 심층학습, 강화학습이라 지칭함. (유튜브, 알파고, 넷플릭스 등)

ㅇ 종류 : 정형/비정형 데이터 마이닝

ㅇ 통계분석은 가설이나 가정에 따른 분석이나 검증을 하지만, 데이터마이닝은 데이터로부터 의미있는 저보를 찾아내는 방법을 통칭

2. 데이터마이닝 방법에 따른 분류

ㅇ 지도학습 : 정답이 있는 데이터를 활용하여 분석 모델을 구축하는 것 (ex. 회귀분석, 의사결정트리, 인공신경망 모형, 로지스틱회귀분석 등)

ㅇ 비지도학습 : 정답이 없는 데이터들 사이의 유사성, 거리를 활용하여 그룹화하거나 규칙을 파악하는 것. (ex. 군집분석, 연관성 분석, SOM)

3. 데이터마이닝 목적에 따른 분류

ㅇ 분류분석 : 대표적인 지도학습으로 데이터가 어느 그룹에 속하는지 판별하기 위한 분석 기법 (ex. 로지스틱 회귀분석, 의사결정나무, 앙상블 분석, 인공신경망 등)

ㅇ 군집분석 : 비지도학습으로 데이터들 사이의 유사성 측정을 통해 데이터를 그룹화하기 위한 분석 기법 (ex. 병합적 방법, 분할적 방법, K평균 군집 등)

ㅇ 연관분석 : 비지도학습으로 데이터 사이의 연관 규칙을 파악하는 분석 기법 (ex. 연관분석(장바구니 분석))

4. 데이터마이닝 과정

ㅇ 목적 정의 : 데이터 마이닝을 수행하기 위한 목적을 설정하고 그에 따른 데이터 및 기법 정의

ㅇ 데이터 준비 : 정의된 데이터를 수집하고 데이터 정제를 통해 품질 보장

ㅇ 데이터 가공 : 데이터 전처리를 통해 데이터 마이닝 기법에 적용가능 데이터로 변환 및 데이터 분할을 수행하는 단계

ㅇ 데이터마이닝 기법 적용 : 데이터 마이닝 기법을 적용하고 모델을 구축하는 단계

ㅇ 모델검증 : 구축된 모델로부터 성능을 검증하는 단계

5. 데이터 분할 개요

ㅇ 데이터 분할은 모형의 과대적합, 과소적합을 방지하며 데이터가 불균형한 문제가 존재할 경우 해당 문제를 해결하기 위해 활용. 일반적으로 훈련용(50%), 검정용(30%), 평가용(20%)로 분할하여 데이터 마이닝을 수행

6. 과대적합과 과소적합

ㅇ 과대적합 : 규제없이 모든 데이터를 설명하려 하는 매우 복잡한 모형 -> (해결방법) 드롭아웃, 가중치 규제

ㅇ 과소적합 : 지나친 규제로 데이터를 충분히 설명하지 못하는 매우 단순한 모형 -> (해결방법) 학습량 및 데이터 증가, 가중치 규제 감소(가중치 완화)

7. 데이터분할 수행방법

ㅇ 홀드아웃 : 가장 보편적인 방법으로 훈련용, 검정용, 평가용이 아닌 훈련용과 테스트용의 2개 셋으로 분할하는 방법

ㅇ K-fold 교차검증 : 데이터를 K개의 데이터셋으로 분할 후 K-1개를 훈련용으로 나머지 1개를 테스트용으로 활용하여 총 K번의 모델 구축을 통한 최종 모델 구축

ㅇ 붓스트랩 : 데이터 부족 문제, 데이터 불균형 문제를 해결하기 위해 표본으로부터 다시 표본을 추출하여 데이터 셋을 생성하는 방법. 복원추출방법으로 추출된 데이터가 다시 추출될 수 있다.

ㅇ 계층별 K-fold 교차검증 : 데이터 불균형이 심한 경우 일반 K-fold 교차검증을 수행한다면 1개의 테스트용 안에는 False의 데이터가 존재하지 않을 수 있으므로 각 범주별로 교차 검증을 위한 집단을 생성하는 방법

<분류분석>

1. 로지스틱 회귀분석

ㅇ 개요 : 일반 회귀분석은 종속변수가 연속형 변수인 경우에 활용하는 반면, 로지스틱 회귀분석은 종속변수가 범주형 변수인 경우 활용. 일반적으로 성공과 실패 2개의 집단에 대해 분류하는 이진분류를 목적으로 활용

ㅇ 오즈 : 성공할 확률이 실패할 확률의 몇 배인지를 나타내는 값 또는 성공횟수를 실패 횟수로 나눈 값이다. 오즈값이 높을수록 성공 확률이 높다. [ 오즈(Odds) = 성공확률(p)/실패확률(1-p) or 성공횟수/실패횟수 ]

ㅇ 로짓변환 : 오즈에 밑이 자연상수 e인 로그를 취하는 작업. 오즈에 로그값을 취한 ln(Odds)을 종속변수로 하여 회귀 추정식을 세우는 작업 [ ln(Odds) = β0 + β1 X X1 + β2 X X2 + … + βk X Xk + ε ] 독립변수 Xk가 한 단위 1이 증가할 때 성공확률. 즉 오즈값은 e의 β^2 만큼 증가하게 된다.

ㅇ 해석

- 위 결과를 통해 회귀모형의 p-value 값은 알 수 없으나 억지로 p-value값을 찾아낸다면 1- pchisq(138.629, df=99) = 0.005302078 로 유의수준 0.05보다 작다. 따라서 위 모형은 통계적으로 유의하다.

- 회귀계수에 대한 p-value값은 3.28e-07 (0000000.328)로 유의수준 0.05보다 작음으로 회귀계수도 통계적으로 유의함을 알 수 있다.

- 추정되는 회귀식은 ln(Odds) = -27.831 + 5.140 X Sepal.Length 이다.

- 위 식은 Sepal.Length 가 1이 증가하면 오즈의 값은 e의 5.14 제곱인 약 170배가 증가하여 성공 집단(그룹 1)에 속할 확률이 170배 증가함을 알 수 있다.

2. 의사결정나무 (Decision Tree)

ㅇ 개요 : 특정 분리 규칙을 찾아내고 그에 따라 몇 개의 소집단으로 데이터를 분류하는 방법. 대표적인 분류분석 기법으로 앙상블 분석의 기반을 제공

ㅇ 구성요소

- 뿌리마디 : 전체 자료를 포함하고 있는 가장 최상위 마디

- 자식마디 : 하나의 마디로부터 나온 2개 이상의 하위마디

- 부모마디 : 모든 자식마디의 바로 상위마디

- 끝마디 : 자식마디가 없는 최하위 마디

- 중간마디 : 부모마디와 자식마디를 보유한 마디(뿌리마디와 끝마디가 아닌 마디)

- 가지 : 부모마디와 자식마디를 연결하는 연결선

- 깊이 : 뿌리마디를 제외한 중간마디의 수

ㅇ 특징

ㅇ 불순도 : 하나의 그룹에 속해 있는 데이터들의 섞여있는 정도를 숫자로써 나타낸 값으로 값이 0이면 단일 원소로 구성되어 있으며, 값이 클수록 데이터들이 지저분하게 섞여있다.

ㅇ 이산형 변수 분리 기준

- CHAID 알고리즘 : 카이제곱 통계량

- CART 알고리즘 : 지니지수

- C4.5 알고리즘 : 엔트로피 지수

ㅇ 연속형 변수 분리 기준

- CHAID 알고리즘 : ANOVA F 통계량

- CART 알고리즘 : 분산 감소량

ㅇ 정지규칙 : 특정 규칙에 따라 분리를 더 이상 수행하지 않고 모델 구축을 종료하는 방법 (ex. 뿌리마디로부터 일정 깊이에 도달할 경우, 불순도의 감소량이 아주 작아 의미가 없는 경우, 마디에 속하는 자료가 일정 수 이하인 경우, 모든 자료들이 하나의 그룹에 속하는 경우)

ㅇ 가지치기 : 모델 구축이 끝난 뒤 모형의 일부 가지를 제거함으로써 과대적합 발생을 사전에 방지하는 방법

ㅇ 해석

- 104개의 훈련용 데이터가 뿌리마디가 시작되며 2개의 자식마디를 보유

- 2번 자식마디는 36개 setosa 중 0개가 잘못 분류되었으며 자식마디가 없음.

- 3번 자식마디는 68개의 virginica 중 33개가 잘못 분류되었음을 의미하며 2개의 자식 마디를 보유

- 6번 자식마디는 30개의 versicolor 중 1개가 잘못 분류되었으며 자식마디가 없음

- 7번 자식마디는 38개의 virginica 중 4개가 잘못 분류되었으며 자식마디가 없음

3. 앙상블분석

ㅇ 개요 : 한 개의 의사결정나무를 구축할 경우 데이터분할에 의존하기 때문에 분할이 불균등할 경우 잘못된 모델이 구축될 수 있기 때문에 신뢰도가 낮은 문제가 존재한다. 이런 문제를 해결하기 위해 앙상블 분석은 여러 개의 의사결정나무를 하나의 모델로 활용하는 것을 의미한다. 보팅이란 여러개의 의사결정나무로부터 얻어진 각각의 결과값을 다수결 방식을 통해 최종 분류값을 선택하는 방법이다. 대표적인 방법으로는 배깅, 부스팅, 랜덤포레스트 등이 있다.

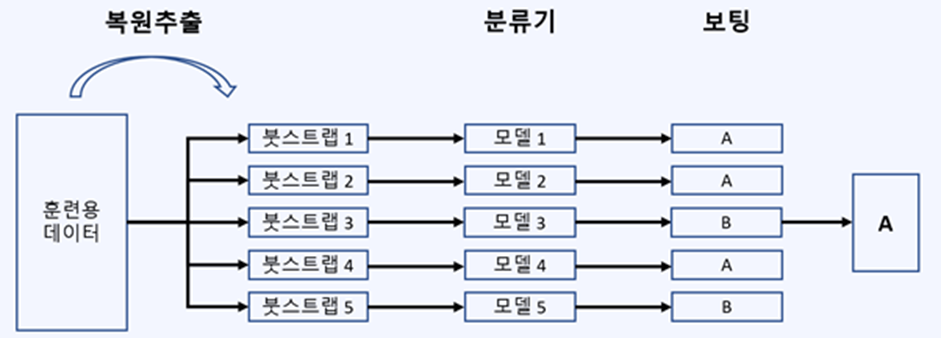

ㅇ 배깅 : n개의 독립적인 붓스트랩을 생성하고 n개의 의사결정나무 구축을 통해 최종 분류값을 결정하는 방법. 다양한 붓스트랩으로 인해 알 수 없던 모집단의 특성을 잘 반영할 수 있으며, 모집단의 특성이 잘 반영된 만큼 분산이 작고 좋은 예측력을 보유.

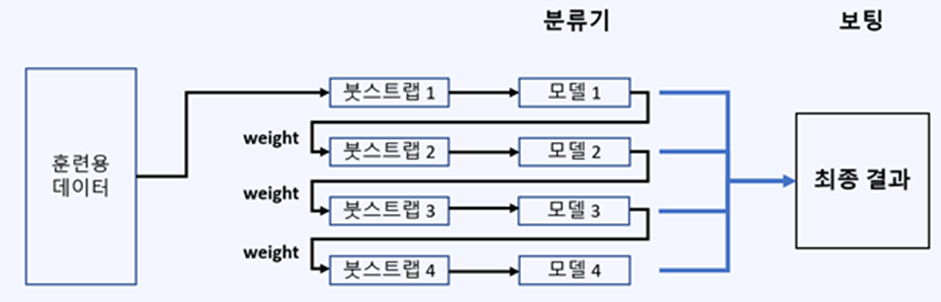

ㅇ 부스팅 : 배깅과 유사한 이전 모델에서 잘못 분류된 데이터에 더 큰 가중치를 주어 새로운 붓스트랩을 구성한다는 점에서 다르다. 약한 분류기들을 결합하여 강한 분류기들을 생성하는 방법이다. (ex. AdaBoosting, Gradient Boost, XGBoost, Light GBM 등) 배깅보다 높은 정확도를 보유하지만 과적합될 가능성이 있으며 이상값에 민감한 단점이 있다.

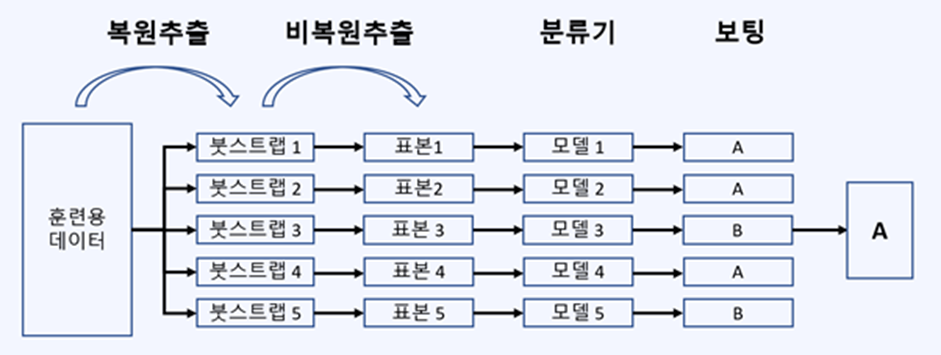

ㅇ 랜덤 포레스트 : 랜덤한 나무들로 이루어진 숲을 의미하며, 배깅과 유사하나 더 많은 무작위성을 가하는 분석기법. 분산이 큰 의사결정나무의 단점을 보완하여 작은 분산을 보유하고 있으며, 나무들이 서로 상관성을 갖지 않아 일반화 성능이 향상되었으며 높은 예측 정확도 보유와 함께 이상값에 민감하지 않은 장점이 있다.

- 배깅과 차이점 : 비복원 추출단계는 데이터의 추출이 아닌 독립변수의 추출로 독립변수 X, Y, Z가 존재할 때 붓스트랩 1에서는 X, Y에 의한 분할을 수행한다면 붓스트랩 2에서는 Y, Z에 의한 분할을 수행할 수 있다는 것이다.

4. 인공신경망

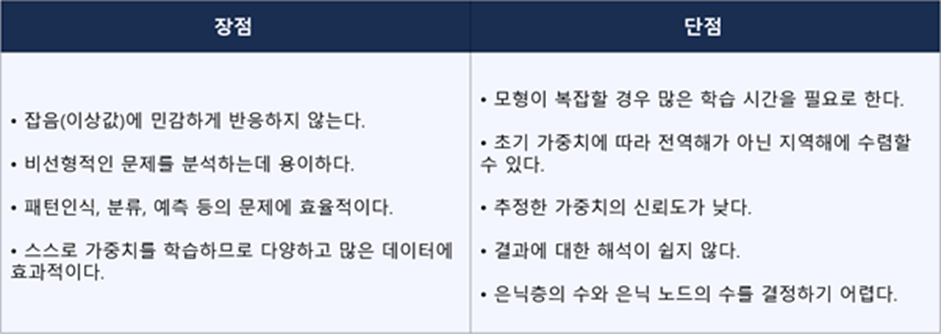

ㅇ 개요 : 여러 개의 입력 신호를 받아 일정 기준치를 초과할 때 활성화되며 출력신호를 내보내는 인간의 뇌의 시냅스를 모방하여 만들어진 학습 및 추론 모형 / 기계학습, 심층학습 그리고 CNN, RNN 등 현대의 다양한 인공지능 서비스의 기반을 제공

ㅇ 구조

- 단층 신경망 : 입력층과 출력층으로 구성된 신경망

- 다층 신경망 : 입력층과 출력층 사이의 1개 이상의 숨겨진 은닉층을 보유한 신경망

ㅇ 특징

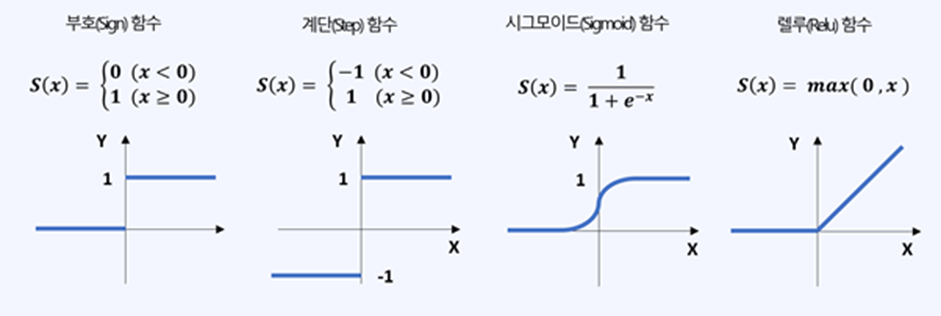

ㅇ 활성화 함수

* 소프트맥스 함수 : 표준화 지수 함수라고도 불리며 연속형 변수를 출력하는 앞선 함수와 달리 각 범주에 속할 확률을 반환

ㅇ 인공신경망 학습 과정

1) 초기 가중치 및 은닉층의 수 은닉 노드의 수를 결정

2) 순전파 알고리즘(입력층 > 출력층)을 통한 오차를 탐색

3) 역전파 알고리즘(출력층 > 입력층)을 통한 가중치 업데이트

4) 모든 데이터를 한번 학습하는 1회의 epoch를 달성

5) 위 2번 ~4번 과정을 일정 epoch 또는 목표 정확도에 도달할 때까지 반복

- 역전파 알고리즘을 수행하는데 있어서 많은 시간이 필요로 하는 단점이 존재한다.

ㅇ 경사하강법 : 많은 시간을 필요로 하는 역전파 알고리즘의 단점을 보완하기 위한 방법. 오차 함수의 최솟값인 전역해를 찾기 위해 현재 위치에서 가장 가파른 내리막길로 이동하는 방법으로 초기 가중치 설정에 영향을 많이 받는 것이 단점이다.

5. 분류모형 성과평가

ㅇ 개요 : 다양한 기법에 의해 구축된 분류 모형은 모두 다른 성능을 보유. 최종 모형을 선정하기 위한 평가 기준이 요구됨

ㅇ 분류모형 평가지표 : 오분류표를 활용한 평가지표, ROC커브, 이익도표

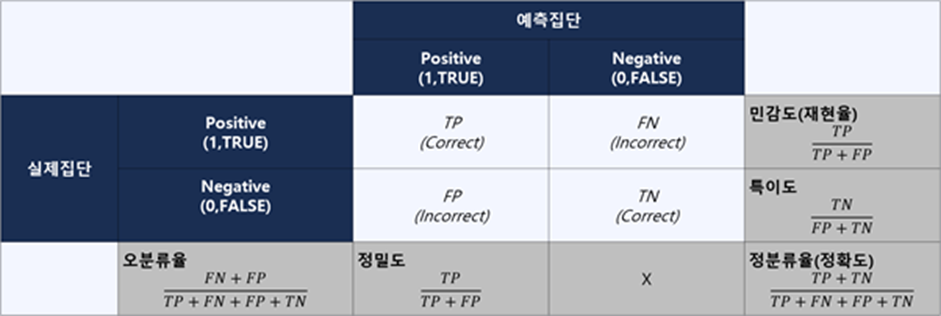

ㅇ 오분류표와 평가지표

- 오분류표 : 혼동행렬이라고 분리며 두 개의 집단을 분류하는 이진분류 모형에 대한 성과평가를 위한 표이다.

* F1 score : 정밀도와 재현율은 높은 확률로 음의 상관관계를 가질 수 있기 때문에 두 지표를 하나의 지표로써 통일화하기 위한 방법으로 정밀도와 재현율을 조화평균 값이다.

. 정분류율(Accuracy) = (TN+TP) / (TN+TP+FN+FP)

. 오분류율(Error Rate) = 1 - Accuracy = (FN + FP) / (TN+TP+FN+FP)

. 특이도(Sepcificity) = TN / (TN + FP)

. 민감도(Sensitivitiy) = TP / (TN + FN)

. 정확도(Precision) = TP / (TP + FP)

. 재현율(Recall) = 민감도 = TP / (TP + FN)

. F1 Score = 2*(정확도*재현율)/(정확도+재현율)

ㅇ ROC커브

- 분류 분석 모형의 평가를 시각화한 그래프로 X 축은 1-특이도 값을, Y 축은 민감도 값을 갖는다.

- 분류 모형의 성과는 ROC커브의 아래면적을 의미하는 AUC(Area Under the ROC Curve)값으로 평가할 수 있으며 면적이 1에 가까울수록 우수한 모형이다

- 무작위로 결과를 찍는 랜덤모형의 경우 AUC 값을 0.5로 가지며, AUC값이 1일 때 완벽한 모형이다.

6. 분류임계값

ㅇ 분류 모형이 집단에 속할 확률을 반환할 경우 성공집단에 속할 기준 값이 필요하다. 일반적인 분류 임계값은 0.5이나 AUC값이 최대가 되는 분류 임계값을 선정한다.

ㅇ 그룹 1에 속할 확률 > 분류 임계값 → 그룹 1에 속하는 것으로 분류

ㅇ 그룹 1에 속할 확률 < 분류 임계값 → 그룹 0에 속하는 것으로 분류

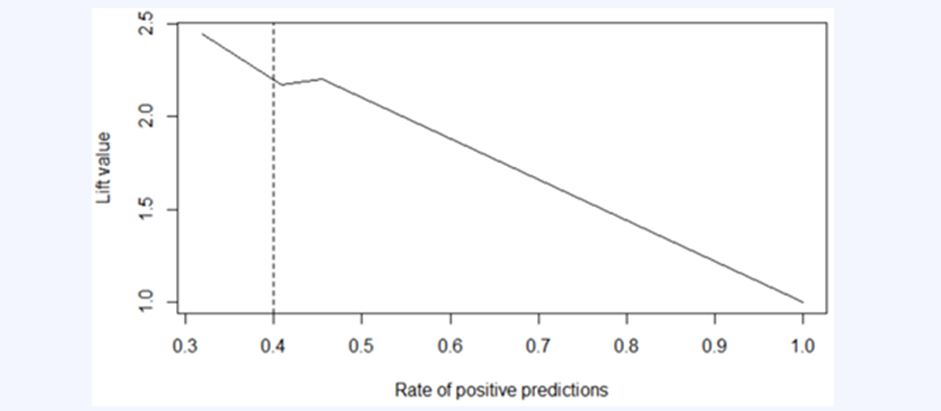

7. 이익도표

ㅇ 이익도표는 랜덤모형에 비교했을 때 구축된 모형의 성능이 얼마나 우수해졌는지 판단하기 위한 목적

ㅇ 향상도 곡선

이익도표를 시각화한 곡선으로 랜덤모델과 비교하였을 때 상위 몇 퍼센트 데이터에 대해서 얼마나 좋은 예측력을 보유했는지 판단하기 위한 목적

- 위 그래프는 상위 40% 데이터에 대해서 랜덤모형에 비교했을 때 2.2배 좋은 예측력을 보유하고 있다.

<관련 기출문제>

2023.02.21 - [자격증공부] - [ADsP] (3과목) 데이터분석 - 데이터마이닝, 분류분석 기출문제

[ADsP] (3과목) 데이터분석 - 데이터마이닝, 분류분석 기출문제

1. 다음 중 로지스틱 회귀분석에 대한 설명 중 가장 부적절한 것은 무엇인가? ① 오즈란 이진 분류에서 실패할 확률 대비 성공할 확률을 의미한다. ② 로지스틱 회귀분석의 종속변수는 범주형이

inform.workhyo.com

<ADsP 요약+기출문제 자료 다운로드(바로가기)>

ADsP 빅데이터분석준전문가 자격증 대비 요약 및 기출 | 10000원부터 시작 가능한 총 평점 0점의 자

0개 총 작업 개수 완료한 총 평점 0점인 WorkHYO의 자료·템플릿, 취업·입시 자료, 기타 서비스를 0개의 리뷰와 함께 확인해 보세요. 자료·템플릿, 취업·입시 자료, 기타 제공 등 10000원부터 시작 가

kmong.com

'자격증공부 > 데이터분석준전문가(ADsP)' 카테고리의 다른 글

| [ADsP] (3과목) 데이터 분석 - 군집분석과 연관분석 요약 (0) | 2023.03.04 |

|---|---|

| [ADsP] (3과목) 데이터 분석 - 데이터마이닝, 분류분석 기출문제 (0) | 2023.02.21 |

| [ADsP] (3과목) 데이터 분석 - 통계분석 Part3 기출문제 (0) | 2023.02.20 |

| [ADsP] (3과목) 데이터 분석 - 통계분석 Part3 요약 (0) | 2023.02.20 |

| [ADsP] (3과목) 데이터 분석 - 통계분석 Part2 기출문제 (0) | 2023.02.20 |